如何吸引搜索引擎“蜘蛛”收录内容

在规划好网站的内容策略以后,下面应该考虑的是如何设计网站内容的更新节奏,让搜索引擎更好地抓取、收录网站内容,进而更好地促进网站关键词的排名和高质量流量的稳步提升。

搜索引擎"蜘蛛"对网页进行爬取,然后抓取这些内容并存入自己庞大的数据库中(收录),再经过一系列处理,最后当用户搜索某个关键词时返回与之相对应的结果。从这个角度而言,保证蜘蛛抓取网页是重要的环节。对搜索引擎优化来说,如何让搜索引擎第一时间发现网站上的最新信息并收录就是很重要的一个方面。

一、蜘蛛的特性与收录

搜索引擎蜘蛛(spider)是一个很形象的名字(也称为机器人bot),它把互联网比喻成一个蜘蛛网,spider就是在网上爬来爬去的蜘蛛。蜘蛛通过网页的链接地址来寻找网页,网站某一个页面(通常是首页)开始,读取网页的内容,找到网页中的其他链接地址,然后通过这些链接地址寻找下一个网页,这样一直寻找下去,直到把这个网站所有的网页都抓取完为止。如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

在通常情况下,蜘蛛完成某个网站的全部内容抓取以后,会隔一段时间又来看一下网站页面是否更新、是否有新产生的内容需要抓取,并根据网站的更新效率等因素逐渐养成爬行此网站的节奏。

通常的说法是:蜘蛛的爬行特性是根据网站的更新节奏而来的,如果网站更新得越频繁,新内容越多,蜘蛛就会爬行得越快,随之而来的收录也就越快。所以,搜索引擎优化来说,要获得好的排名的基础,就是保证网页的收录,保证蜘蛛对网站有良好的爬行节奏。

二、稳定的更新节奏与"圈养"蜘蛛

在站长圈子中曾经有一种玩笑说法,叫做"圈养"蜘蛛,大概意思就是让蜘蛛保持对当前网站的热衷,提高爬行效率,增加网站内容收录的速度。这种说法虽然玩笑成分居多,但是从搜索引擎优化的角度而言,却是有一定道理的。

简单来说,要达到"圈养"蜘蛛的目的需要两个条件:

①有足够多的新内容

②这些新内容有良好的更新节奏。

如果一个网站没有足够多的新内容,蜘蛛在爬行完成以后就会变得比较懒,来访问网站的节奏会逐渐延长,及时收录新页面的机会也就降低了。如果网站采用一次更新大量内容,然后长时间不更新的方式来建设内容,蜘蛛对新页面的抓取效率同样也不会高。

基于上面的原因,对中小型网站而言就需要养成频繁更新、稳定更新优质内容的节奏。要实现这样的效果,在解决了内容储备之后,如果有一个可以按照固定节奏,代替人工更新的插件就好了。

三、中小型网站站长的福音:自动审核、自动更新的神奇插件

在当前的主流CMS系统中,具有自动审核文章、自动更新页面功能的系统还不多,不过一些有丰富的搜索引擎优化经验的站长已经尝试开发出了这样的插件,可以解放双手。

以织梦为例,"自动审核、自动更新"插件是开源的,任何站长都可以采用。这个插件的基本功能是实现对后台未审核内容按设置频率进行审核,然后在审核的同时更新页面。

这个插件是开源免费的,设置步骤不难,但是涉及文件比较多,这里无法详细介绍。相关插件下载和详细设置方法可以到百度上进行搜索。

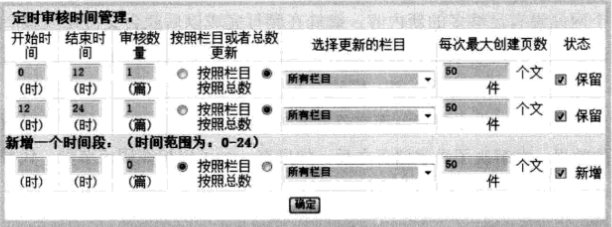

部署完这个插件以后,登陆织梦后台,在"核心"模块下有一项"定时审核管理",如图所示:

选择此项以后,搜索引擎优化者可以按照每天24小时的方式,定义是否审核后台未审核文章以及审核几篇,如图所示:

在通常情况下,要实现"圈养"蜘蛛的目的,在内容储备足够时,搜索引擎优化者可以设置每个小时审核数篇文章,并自动在审核文章以后更新网站的首页、栏目页和内容页。

设置好以后,当网站"未审核文章"中有文章时,网站只要有访问者,均可按设定的条件触发自动审核、自动更新功能。

"未审核文章"就是网站建设者已经发布到网站数据库中,但是没有设置开放浏览的文章,这样的文章是无法被来访者看到的,只有通过审核之后才会显示在网站页面中供来访者浏览。

通过部署这个功能,搜索引擎优化者可以根据网站规模,实现每个星期或每个月批量发布文章,然后让插件实现每天更新几篇、几十篇的功能,对新页面的收录非常有帮助。

上述插件和功能比较适合中小型网站采用,特别是在负责编写文章的人不多的情况下;对大型站点来说,有足够的采编队伍,那就没有必要采用这个方法了。

想了解更多SEO技术的内容,请访问:SEO技术